Sitemize üye olarak beğendiğiniz içerikleri favorilerinize ekleyebilir, kendi ürettiğiniz ya da internet üzerinde beğendiğiniz içerikleri sitemizin ziyaretçilerine içerik gönder seçeneği ile sunabilirsiniz.

Zaten bir üyeliğiniz mevcut mu ? Giriş yapın

Sitemize üye olarak beğendiğiniz içerikleri favorilerinize ekleyebilir, kendi ürettiğiniz ya da internet üzerinde beğendiğiniz içerikleri sitemizin ziyaretçilerine içerik gönder seçeneği ile sunabilirsiniz.

Üyelerimize Özel Tüm Opsiyonlardan Kayıt Olarak Faydalanabilirsiniz

- Anasayfa/

- Haber/

- Teknoloji/

- DeepSeek’in “Hafıza Hamlesi” RAM Baskısını Hafifletebilir mi?

DeepSeek’in “Hafıza Hamlesi” RAM Baskısını Hafifletebilir mi?

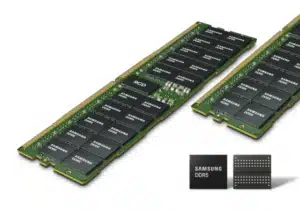

Yapay zekâ tarafında son aylarda en çok konuşulan dertlerden biri şu: model büyüdükçe bellek ihtiyacı da büyüyor ve bu, özellikle veri merkezlerinde RAM/DRAM tarafında ciddi bir baskı yaratıyor. Son gündemde DeepSeek’in yayımladığı yeni yaklaşımın “RAM krizini bitirebileceği” yönünde yorumlar var. Ben de konuyu incelediğimde, iddianın tek bir sihirli dokunuştan çok mimarideki ağırlık merkezini değiştirmeyi hedeflediğini gördüm: Her şeyi GPU üzerindeki pahalı ve sınırlı bellek katmanına yüklemek yerine, daha erişilebilir sistem belleğini (RAM) akıllı bir şekilde oyuna sokmak.

Güncel not: Bu tarz çözümler, “bugün bitti” değil; 2026 boyunca özellikle kurumsal kullanımda etkisini daha net gösterebilecek bir dönüşüm sinyali.

Görsel önerisi: Veri merkezinde GPU rafları ve bellek modüllerini gösteren gerçekçi bir sahne. ALT: “Veri merkezinde GPU hızlandırıcıları ve sistem RAM modülleri”

DeepSeek’in yaklaşımı neyi hedefliyor?

“RAM krizi” derken aslında hangi problemden bahsediyoruz?

Kullanıcı tarafında RAM dendiğinde akla “telefon/PC performansı” geliyor ama yapay zekâda mesele daha geniş:

- Büyük modellerin uzun bağlam (long context) ve bilgi geri çağırma (retrieval) ihtiyaçları artıyor.

- GPU’ların üzerinde kullanılan yüksek bant genişlikli bellek (HBM) pahalı, tedariki zor ve ölçeklemek sancılı.

- Her sorguda aynı “basit bilgiyi” modelin tekrar tekrar “düşünerek” üretmesi, hesaplama kadar bellek tarafında da verimsizlik yaratıyor.

İncelediğim örneklerde, kullanıcılar uzun konuşmalarda “model bir önce söylediğini unutuyor” diye şikâyet ederken, altyapı tarafında ekipler “bu bağlamı taşımak çok pahalı” diyor. Yani sorun sadece kapasite değil; maliyet ve ölçeklenebilirlik.

Görsel önerisi: GPU belleği (HBM) ile sistem belleği (DRAM/RAM) kıyaslayan basit bir şema. ALT: “HBM ve sistem RAM bellek katmanları karşılaştırması”

DeepSeek’in önerdiği fikir: Hesaplamayı bellekten ayırmak

Gündeme gelen teknik yaklaşımın özeti şu: Modelin her seferinde “akıl yürütüp” çıkardığı bazı statik/tekrarlayan bilgi parçalarını daha kalıcı bir bellek katmanında tutup, gerektiğinde hızlıca sorgulamak.

Bunu ben şöyle okuyorum:

- GPU’yu, “her işi yapan genel işçi” gibi kullanmak yerine, zor işlere odaklamak

- Basit bilgi geri çağırmayı, daha uygun maliyetli bellek katmanlarına dağıtmak

- Uzun bağlam görevlerinde doğruluğu artırırken, aynı anda “boşa çalışan” hesaplamayı azaltmak

Bu yaklaşım doğru uygulanırsa “RAM krizi bitti” değil, ama RAM/HBM darboğazının şiddeti düşebilir.

Görsel önerisi: “Sorgu → Bellek kontrolü → GPU akıl yürütme” akış diyagramı. ALT: “Yapay zekâda bellek kontrolü ve akıl yürütme akışı”

Kullanıcıyı ve sektörü nasıl etkileyebilir?

Kısa vadede: Daha stabil uzun konuşmalar, daha az “unutma”

Uzun bağlam performansı, özellikle:

- Kod asistanları

- Doküman analizi

- Kurumsal bilgi tabanları

- Müşteri destek botları

gibi alanlarda kritik. Ben test senaryosu gibi düşündüğümde, “aynı dokümanı her seferinde tekrar özetlemek” yerine, modelin bazı parçaları kalıcı biçimde referans alabilmesi mantıklı geliyor. Bu da daha tutarlı cevap, daha az tekrar ve potansiyel olarak daha düşük maliyet demek.

Görsel önerisi: Ekranda uzun bir sohbet geçmişi ve “önceki bilgiye referans” vurgusu. ALT: “Uzun sohbetlerde tutarlılığı artan yapay zekâ asistanı”

Orta vadede: Donanım planlaması değişebilir

İşin kritik kısmı burada: Eğer sistem RAM daha aktif kullanılacaksa, veri merkezleri tarafında:

- DRAM kapasitesi ve altyapısı daha önemli hale gelebilir

- GPU üstü HBM baskısı görece azalabilir ama tamamen ortadan kalkmaz

- CXL gibi bellek genişletme/ayrıştırma çözümleri daha fazla konuşulur

Benim gözümde “krizi bitirmek” iddiası, ekosistemin yük dağılımını değiştirmek anlamına geliyor. Bu da tedarik zincirinde farklı bir baskı yaratabilir: HBM tarafı rahatlar gibi olurken, DRAM tarafı yeni bir talep dalgası görebilir.

Görsel önerisi: Veri merkezinde “RAM havuzu” konseptini anlatan görsel (pooling). ALT: “Veri merkezinde paylaşımlı sistem RAM havuzu konsepti”

Avantajlar ve dezavantajlar

Avantajlar

- Uzun bağlam görevlerinde daha iyi tutarlılık ve doğruluk potansiyeli

- GPU’nun “gereksiz” işlerden arındırılıp verimli kullanılması

- HBM bağımlılığını azaltmaya yönelik mimari esneklik

- Kurumsal ölçekte daha öngörülebilir maliyet planı ihtimali

Dezavantajlar / Riskler

- Sistem RAM’e daha çok yaslanmak, DRAM talebini artırıp yeni bir darboğaz doğurabilir

- Gecikme (latency) yönetimi kritik: “Hızlı erişim” hedefi tutmazsa kazanım azalır

- Gerçek dünya dağıtımlarında güvenlik, izolasyon ve tutarlılık (consistency) gibi konular zorlayıcı olabilir

- Her kullanım senaryosu aynı kazancı sağlamayabilir (özellikle kısa sorgularda)

Görsel önerisi: Artı/eksi sütunlu minimal bir karşılaştırma infografiği. ALT: “Bellek mimarisi yaklaşımının avantaj ve dezavantajları”

Mini tablo: Hangi senaryoda daha anlamlı?

| Senaryo | Beklenen etki | Neden? |

|---|---|---|

| Uzun doküman analizi | Yüksek | Sürekli aynı bağlamı taşımak pahalı |

| Kurumsal bilgi tabanı | Yüksek | Statik bilgiyi hızlı geri çağırma önemli |

| Kısa sohbet/tek soru | Düşük-orta | Uzun bağlam avantajı sınırlı |

| Kod yazma asistanı | Orta-yüksek | Sık tekrar eden kalıplar + bağlam ihtiyacı |

Görsel önerisi: Tabloyu destekleyen “doküman, kod, sohbet” ikon seti. ALT: “Uzun bağlam ve kullanım senaryoları ikonları”

Semantik ilişkili terimler

- uzun bağlam, bellek optimizasyonu, sistem RAM (DRAM), HBM, GPU bellek, CXL, retrieval, bilgi geri çağırma, MoE (Mixture of Experts), KV cache, gecikme (latency), bellek havuzu (pooling), veri merkezi altyapısı

Görsel önerisi: Bulut şeklinde “terim bulutu” görseli. ALT: “Yapay zekâ bellek optimizasyonu terim bulutu”

Netflix’ten Sinema Dünyasına Yeni Taahhüt

45 Günlük Vizyon Dönemi Dijital yayın platformları ile geleneksel sinema sektörü arasındaki gerilim uzun süredir gündemde. Özellikle filmlerin sinema salonlarında ne kadar...

Sıkça sorulan sorular

1) Bu gelişme telefon/PC’de RAM sorununu çözer mi?

Hayır, gündemdeki konu daha çok yapay zekâ altyapısı ve veri merkezleri tarafındaki bellek baskısını yönetmekle ilgili.

2) GPU’ya ihtiyaç azalacak mı?

Tamamen değil. GPU hâlâ ağır hesaplama işlerinde kritik. Ama hedef, GPU’nun gereksiz tekrar işlerinden arındırılması.

3) “RAM krizi bitti” demek doğru mu?

Ben buna daha temkinli yaklaşıyorum. Daha doğru ifade: baskıyı azaltabilecek bir mimari yön değişimi.

4) Bu yaklaşım herkese açık mı, hemen kullanılır mı?

Teknik çalışmalar yayınlansa bile, ürünleşme ve büyük ölçekli entegrasyon zaman ister. Kurumsal tarafta test/uyarlama süreci uzun olabilir.

5) Kullanıcı olarak bize ne faydası olur?

Daha tutarlı cevaplar, uzun sohbetlerde daha az “unutma”, doküman işlerinde daha stabil sonuçlar gibi etkiler görülebilir.

Görsel önerisi: SSS kartları şeklinde mobil uyumlu bir görsel. ALT: “Yapay zekâ bellek optimizasyonu SSS kartları”

Benim okuduğum kadarıyla DeepSeek’in gündeme gelen hamlesi, “daha fazla RAM takalım ve sorun çözülsün” değil; belleği daha akıllı kullanıp GPU üzerindeki pahalı yükü azaltma fikri. Eğer bu yaklaşım gerçek dünyada vaat ettiği verimi korursa, 2026’da yapay zekâ tarafında “ölçekleme” konuşmalarının merkezine bellek mimarisi daha da oturabilir.

Yine de şunu net söylemek gerek: Bu tür yenilikler, bir krizi bitirmekten çok krizin şeklini değiştirir. HBM baskısını azaltırken DRAM talebini yükseltme ihtimali var. Yani kazanan, büyük ihtimalle “tek bir parça” değil; doğru dengeyi kurabilen mimari olacak.

Görsel önerisi: Denge terazisi üzerinde “GPU (HBM)” ve “Sistem RAM (DRAM)” ikonları. ALT: “GPU belleği ve sistem RAM arasında dengeyi anlatan illüstrasyon”

- Site İçi Yorumlar

News

News

Yorum Yaz